本日、完全にオンデバイスで動作する推論モデル LFM2.5-1.2B-Thinking をリリースします。本モデルはスマートフォン上で 900MB未満のメモリ に収まり、そのサイズにおいて 最速の推論速度と最高水準の品質 を実現しています。2年前にはデータセンターが必要だった処理が、今ではポケットの中でオフライン実行可能になりました。

さらに、私たちはエコシステムを拡大し、新たなローンチパートナーとして Qualcomm Technologies, Inc.、Ollama、FastFlowLM、Cactus Compute を迎えました。これらは、既存のパートナーである AMD および Nexa AI に加わります。これらのパートナーシップにより、車載、スマートフォン、ノートPC、IoT、組み込みシステム全体にわたる強力な導入シナリオが実現します。

LFM2.5-1.2B-Thinking は、本日より Hugging Face、LEAP、そして Playground にてご利用いただけます。

ベンチマーク

LFM 2.5-1.2B-Thinking は、LFM2.5 ファミリーへの最新の追加です。推論タスク専用にトレーニングされた、12億パラメータのモデルです。回答を出す前に思考のトレースを生成し、問題を体系的に解決します。このモデルは、LFM 独自の高速な推論能力を活用して、より高品質な回答を生成します。

LFM2.5-1.2B-Instruct と比較すると、数学的推論(MATH-500:63 → 88)、指示追従(Multi-IF:61 → 69)、ツール使用(BFC Lv3:49 → 57)の3つの能力が大幅に向上しています。

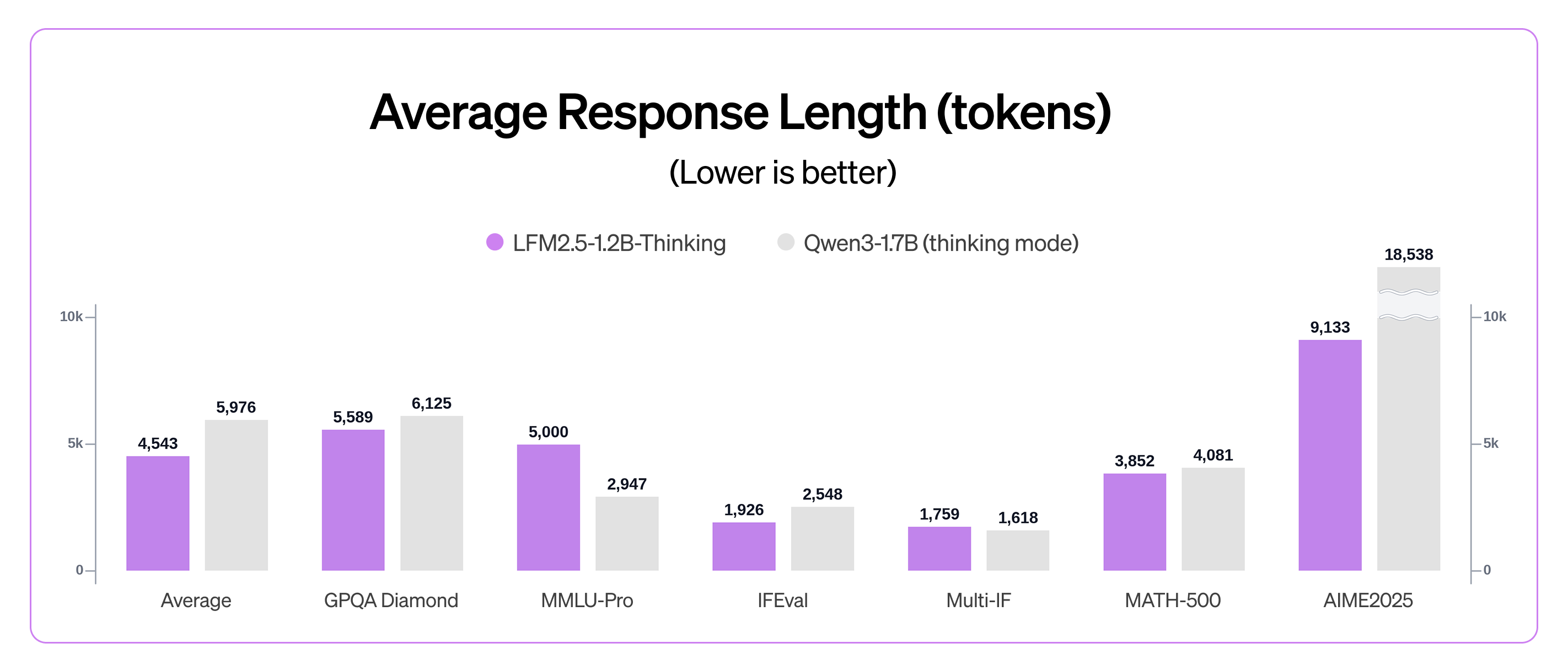

LFM2.5-1.2B-Thinking は、パラメータ数が40%少ないにもかかわらず、ほとんどの推論ベンチマークにおいて Qwen3-1.7B と同等、もしくはそれを上回る性能を示します。さらに、高品質と効率的なテスト時推論計算の両立を実現しています。Qwen3-1.7B(Thinking モード)と比較すると、全体的な性能が高く、必要な出力トークン数も少なくて済みます。

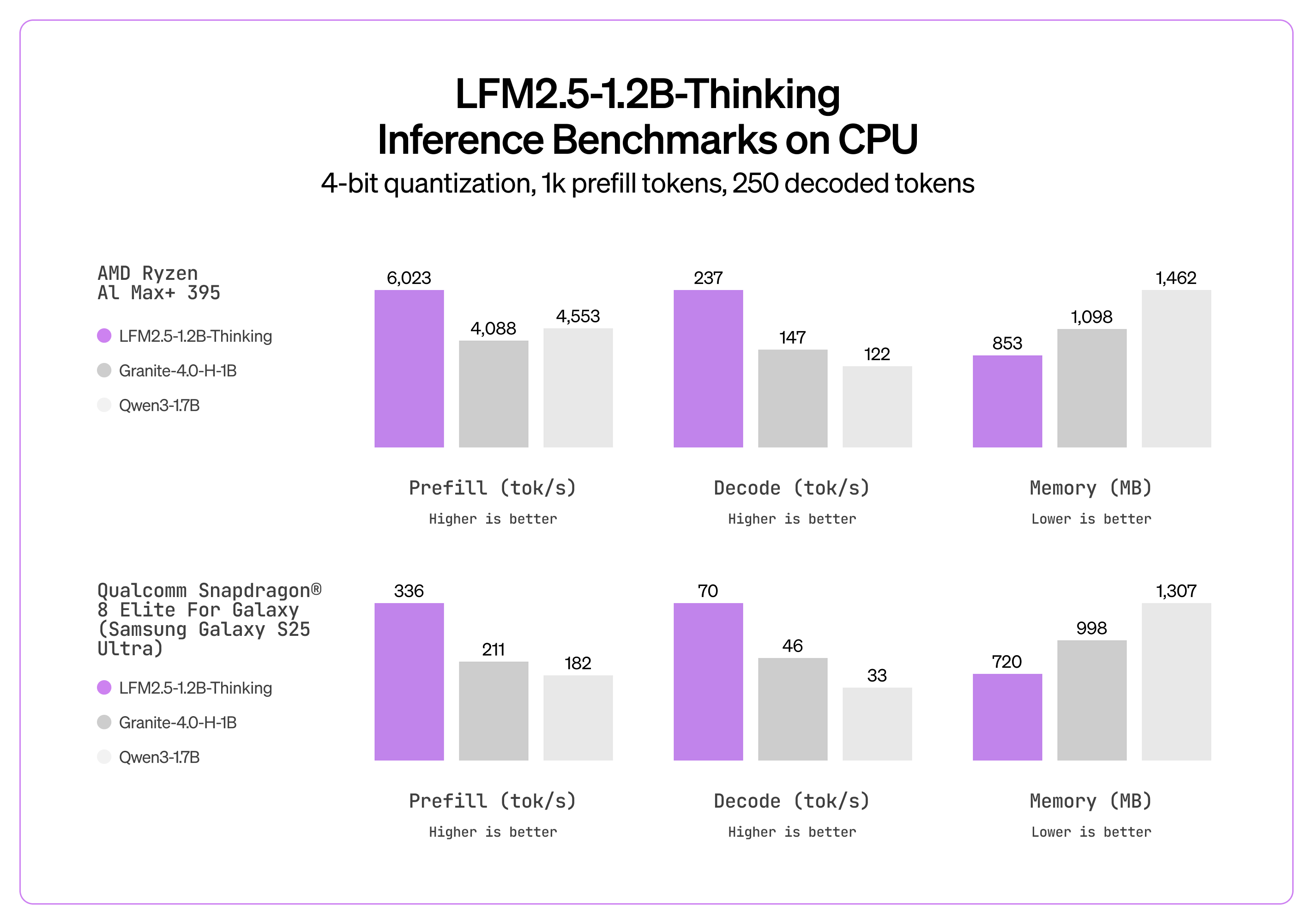

推論時にはパフォーマンス差がさらに拡大し、LFM2.5-1.2B-Thinking は Qwen3-1.7B だけでなく、速度とメモリ効率の両面において Granite-4.0-H-1B のようなハイブリッドアーキテクチャも上回ります。

LFM2.5-1.2B-Thinking は、エージェント性が求められる推論集約型のタスク(例:ツール使用、数学、プログラミング)において、モデルが一連のツール呼び出しを計画し、中間結果を検証し、アプローチを調整する必要がある場合に、推論トレースが真の価値を発揮します。一方で、チャット用途やクリエイティブライティングには LFM2.5-1.2B-Instruct の使用をおすすめします。

トレーニングレシピ

優れた小規模な Thinking モデルを構築するには、低レイテンシーなエッジ導入に適した簡潔な回答を維持しつつ、多段階推論を通じて限られた知識容量を拡張する必要があります。

LFM-1B-Math の以前の実験では、トレーニング中に推論トレースを含めることで、モデルが「まず理由付けを行い、その後に回答する」というパターンを内面化するのに役立つことが示されました。合成された推論トレースを用いた教師あり微調整(SFT)により、より信頼性の高い思考連鎖の生成が可能になり、特定フォーマットへの報酬付与は不要となります。

しかし、SFT だけでは推論モデルによく見られる問題を解決できません。すなわち、結論に到達する代わりに、繰り返しの多いテキストパターンに陥ってしまうことです。この挙動は一般に「ドゥームループ」と呼ばれます。私たちは、いくつかのシンプルな手法によってこれを軽減しました。

プリファレンス配置では、SFT チェックポイントから温度サンプリングされた5つの候補と、1つの greedy 候補を生成しました。採用された回答は LLM 審査員によって最も高いスコアを獲得した候補であり、却下された回答は、ループが存在しない場合には最低スコアの候補、または(審査員スコアに関係なく)ループが検出されたすべての候補でした。RLVR ではさらに、N-gram ベースの繰り返しペナルティを適用し、トレーニング初期段階からループ挙動を抑制しました。

このアプローチにより、代表的なプロンプトデータセットにおいて、ドゥームループの割合は 15.74%(トレーニング中)から 0.36%(RLVR 後)へと大幅に低減しました。

私たちの RL パイプラインは、verl [1] の内部フォーク上に構築されており、クリティックを用いない、グループ相対型ポリシー勾配最適化(GRPO スタイル)に焦点を当てています。基本実装は参照不要で、非対称比率クリッピング、ゼロ分散プロンプトグループの動的フィルタリング、過度に長いサンプルのマスキング、アドバンテージなしの正規化、重要度切り捨てサンプリング([2–6] など)といった手法を取り入れています。各構成要素はターゲットドメインごとに調整されます。検証可能なタスクにはルールベースの報酬を、自由形式のプロンプトには生成型報酬モデルを使用します。また、クロストークナイザーによるポリシーベース抽出を主目的または補助目的として検討しましたが、現時点では大きな効果は確認されていません。

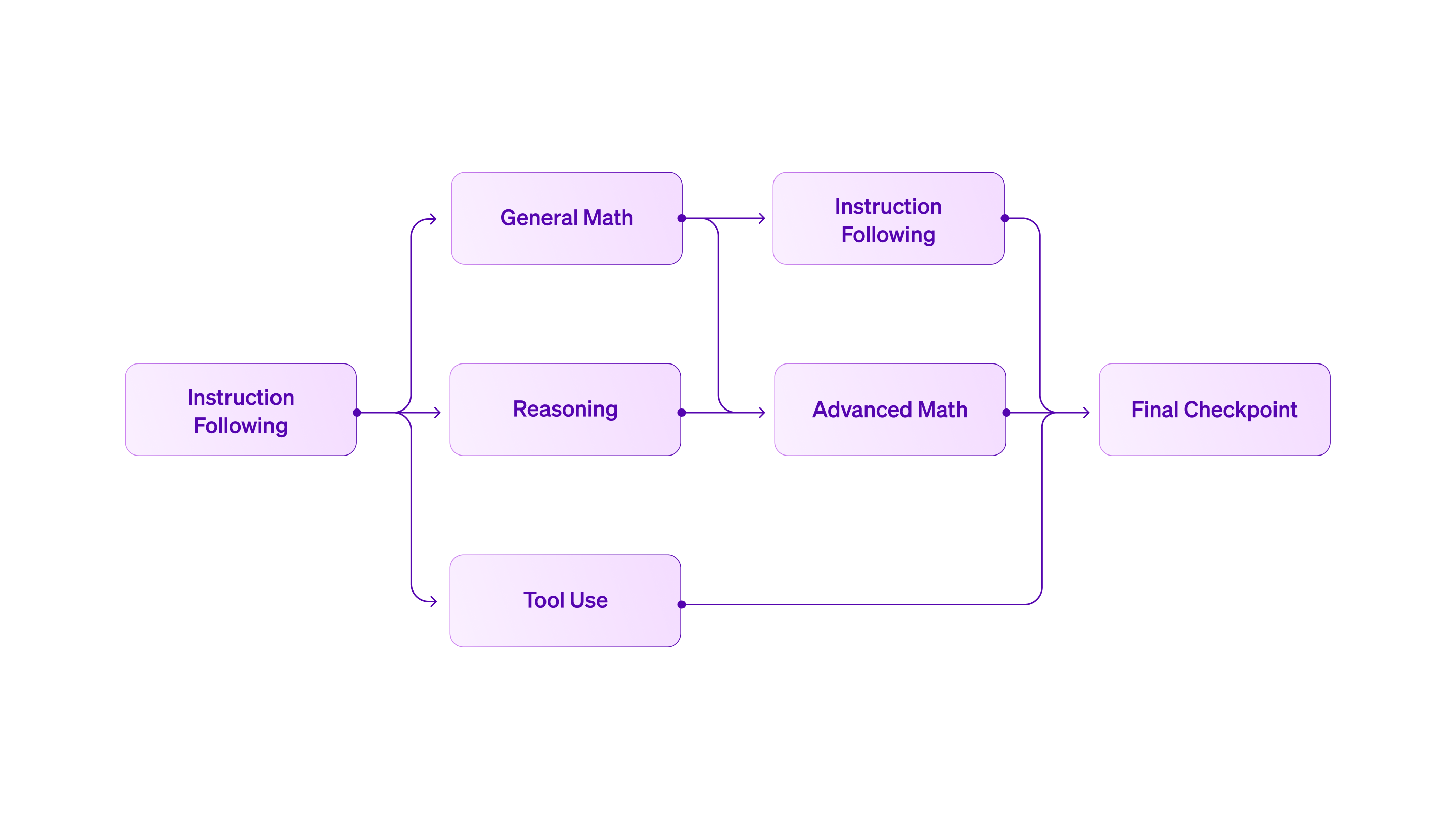

私たちは、高度に並列化された構造を持つ カリキュラム RL アプローチを採用しました。1つのモデルを複数ドメインで同時にトレーニングするのではなく、まず RLVR に基づく指導から開始し、その後、推論・数学・ツール使用といったドメイン固有のチェックポイントへと分岐させます。

この並列アプローチは、すべてのドメインを単一モデルで同時にトレーニングする従来手法とは対照的です。従来手法では、能力間の干渉が生じやすく、回帰の診断も困難になります。私たちのカリキュラムでは、より細かな制御が可能です。各ドメイン固有モデルは、それぞれ独自の報酬設計、ハイパーパラメータ、評価基準を用いて個別に最適化されます。その後、反復的なモデルマージを通じて、目的とする能力をバランスよく統合した新しいチェックポイントを作成します。たとえば、ツール使用に特化したトレーニングの後、以前に数学向けに最適化されたチェックポイントと統合することで、低下した数学推論性能を回復させます。この柔軟性により、純粋な逐次トレーニングよりも能力間のトレードオフを効果的に管理できます。

このアプローチは、小規模で集中したチームにとっても効率的です。独立したワークストリームは互いにブロックすることなく、それぞれのドメインで迅速に反復を行えます。共同でトレーニングを実施するよりも、個別に進めたトレーニング成果を統合する方が、貢献内容を容易に集約できます。モデル統合は、専門的な改善を取り込みつつ全体性能を維持できるため、汎用 RLVR をスケールさせるための実践的な手法であることが分かりました。

LFM エコシステムの拡大

LFM2.5 は、TRL および Ollama ですぐに微調整できます。LFM2.5-1.2B-Thinking は、llama.cpp、MLX、vLLM、ONNX Runtime など、主要な推論フレームワーク全体において、デイゼロサポート付きでリリースされます。これらすべてのフレームワークは、Apple、AMD、Qualcomm、NVIDIA ハードウェアにおける CPU および GPU アクセラレーションの両方をサポートしています。

LFM2.5 モデルの全ファミリーはこちらからご覧いただけます。

LFM2.5 ファミリーを必要な場所で効率的に稼働させるため、私たちはハードウェアおよびソフトウェアのエコシステムを急速に拡大しています。Qualcomm Technologies, Inc.、Ollama、FastFlowLM、Cactus Compute が、新たなローンチパートナーとして参加しました。

「私たちは、Liquid AI のオープンウェイトモデル LFM2.5-1.2B-Thinking のローンチパートナーであることを誇りに思っています。Nexa AI により NPU 向けに最適化することで、開発者は Snapdragon 搭載デバイス上で、よりスマートで高速なオンデバイス AI を実現でき、パフォーマンスに加えてプライバシーとエッジでの信頼性も両立できます。」— Qualcomm Technologies, Inc. プロダクトマネジメント担当バイスプレジデント、ヴィネシュ・スクマール氏

この拡張により、ハードウェアおよびソフトウェアのサポートは大幅に拡充されます。既存パートナーである Nexa AI は、Qualcomm Technologies, Inc. の NPU 上で最適なパフォーマンスを実現しており、FastFlowLM は AMD Ryzen™ NPU デバイス向けの専用高性能ランタイムを提供するために参画しています。さらに、Ollama と Cactus Compute もローンチパートナーとして加わり、シームレスなローカルおよびエッジデプロイメントのワークフローを実現します。

以下の表は、これらの最適化された実装によって実現される推論アクセラレーションを示しています。

LFM2.5-1.2B-Thinking の推論速度ベンチマーク

LFM2.5-1.2B-Thinking は、ロングコンテキスト推論に優れています。たとえば、FastFlowLM を搭載した AMD Ryzen™ NPU では、16K コンテキスト時に最大 52 トークン/秒のデコードスループットを達成し、フル 32K コンテキストでも最大 46 トークン/秒を維持します。これは、ロングコンテキストにおける高いスケーラビリティを示しています。

FastFlowLM 搭載の AMD Ryzen™ NPU におけるロングコンテキスト・ベンチマークの詳細については、以下の こちら をご覧ください。

始めよう

リリース以降、LFM2 ファミリーが Hugging Face において 600 万ダウンロードを突破したことをお知らせできることを誇りに思います。

-%20blog.png)

LFM2.5 により、私たちは「どこでも実行できる AI」というビジョンを実現しています。これらのモデルは以下の特長を備えています。

オープンウェイト — 制限なくダウンロード、微調整、導入が可能

初日から高速 — Apple、AMD、Qualcomm Technologies, Inc.、NVIDIA ハードウェアにおいて、llama.cpp、NexaSDK、Cactus Engine、LM Studio、Ollama、FastFlowML、MLX、vLLM のネイティブサポートを提供

完全なファミリー — カスタマイズ向けのベースモデルから、音声やビジョン向けの特殊バリエーションまで、単一のアーキテクチャで多様なユースケースに対応

エッジ AI の未来はここにあります。皆さんが何を構築するのか、楽しみにしています。

参考文献

[1] Sheng, Guangming, et al. “HybridFlow: A Flexible and Efficient RLHF Framework.” arXiv, 2024.

[2] Ahmadian, Arash, et al. "Back to basics: Revisiting reinforce style optimization for learning from human feedback in llms." arXiv, 2024.

[3] Shao, Zhihong, et al. "Deepseekmath: Pushing the limits of mathematical reasoning in open language models." arXiv, 2024.

[4] Yu, Qiying, et al. "Dapo: An open-source llm reinforcement learning system at scale." arXiv, 2025.

[5] Liu, Zichen, et al. "Understanding r1-zero-like training: A critical perspective." arXiv, 2025.

[6] Yao, Feng, et al. “Your Efficient RL Framework Secretly Brings You Off-Policy RL Training.” Feng Yao's Notion, 2025.

引用

この記事を引用する場合は、以下の形式をご使用ください。

Liquid AI, "LFM2.5-1.2B-Thinking: On-Device Reasoning Under 1GB", Liquid AI Blog, Jan 2026.

または、BibTeX 形式の引用をご利用ください。

@article{liquidAI2026thinking,

author = {Liquid AI},

title = {LFM2.5-1.2B-Thinking: On-Device Reasoning Under 1GB},

journal = {Liquid AI Blog},

year = {2026},

note = {www.liquid.ai/blog/lfm2-5-1-2b-thinking-on-device-reasoning-under-1gb},

}

エンタープライズ向けデプロイメントおよびカスタムソリューションについては、営業チームにお問い合わせください。実装の詳細については、テクニカルレポート をご覧ください。

GPQA、MMLU-Pro、iFBench、AIME25 は Artificial Analysis の方法論 に基づいて評価されています。iFEval および Multi-IF については、プロンプトおよび指示の厳密・非厳密な評価条件における平均スコアを報告します。BFCLv3 では、ツール使用テンプレートをサポートするため、カスタム Liquid ハンドラーを用いて最終的な加重平均スコアを報告します。

.svg)