本日、エッジ AI 展開向けとしてこれまでで最も高性能なリリースとなる LFM2.5-1.2B モデルファミリーを発表できることを大変嬉しく思います。本モデルは、LFM2 のデバイス最適化アーキテクチャを基盤としており、エッジ上で信頼性の高いエージェントを構築するための大きな飛躍を実現しています。事前学習は 10T トークンから 28T トークンへと拡張され、さらに強化学習を用いたポストトレーニングパイプラインを大幅にスケールさせることで、1B モデルが達成できる性能の限界を押し広げました。本リリースは、Base、Instruct、日本語、Vision-Language、Audio-Language モデルを含む包括的なものです。

LFM2.5 は、オンデバイスのエージェント型 AI を構成する中核として、指示追従能力に最適化されています。LFM2.5 により、あらゆるデバイス上でプライベートかつ高速で、常時利用可能なインテリジェンスへのアクセスが可能になります。新しい Text モデルは、高性能なオンデバイスワークフローにおいて妥協のない品質を提供します。Audio モデルは前世代比で 8 倍高速であり、車載機器、モバイル、IoT デバイスといった制約のあるハードウェア上でネイティブに動作します。さらに、VLM は複数画像・多言語に対応した視覚理解および指示追従能力を強化し、エッジ環境におけるマルチモーダルなユースケースを支援します。

すべてのモデルはオープンウェイトで、Hugging Face および LEAP にて本日より利用可能です。また、ローンチパートナーである AMD および Nexa AI が、NPU 上で最適化されたパフォーマンスを提供していることをお知らせします。

言語モデル

LFM2.5 シリーズの基盤を成すのは、汎用言語モデルです。ビルダーの皆様がユースケースに応じてより適切なソリューションを構築できるよう、Base と Instruct の両バリアントをリリースします。

LFM2.5-1.2B-Base は事前学習済みチェックポイントであり、すべての LFM2.5-1.2B バリアントの作成に使用されます。言語別またはドメイン特化型アシスタントの構築、プロプライエタリデータを用いた学習、新しいポストトレーニング手法の実験など、集中的なファインチューニングを必要とするタスクに推奨されます。

LFM2.5-1.2B-Instruct は汎用の指示調整済みバリアントであり、ほとんどのユースケースに適しています。教師ありファインチューニング、選好アライメント、大規模なマルチステージ強化学習によって学習されており、初期状態から優れた指示追従性能とツール利用能力を発揮します。

テキストモデルのベンチマーク

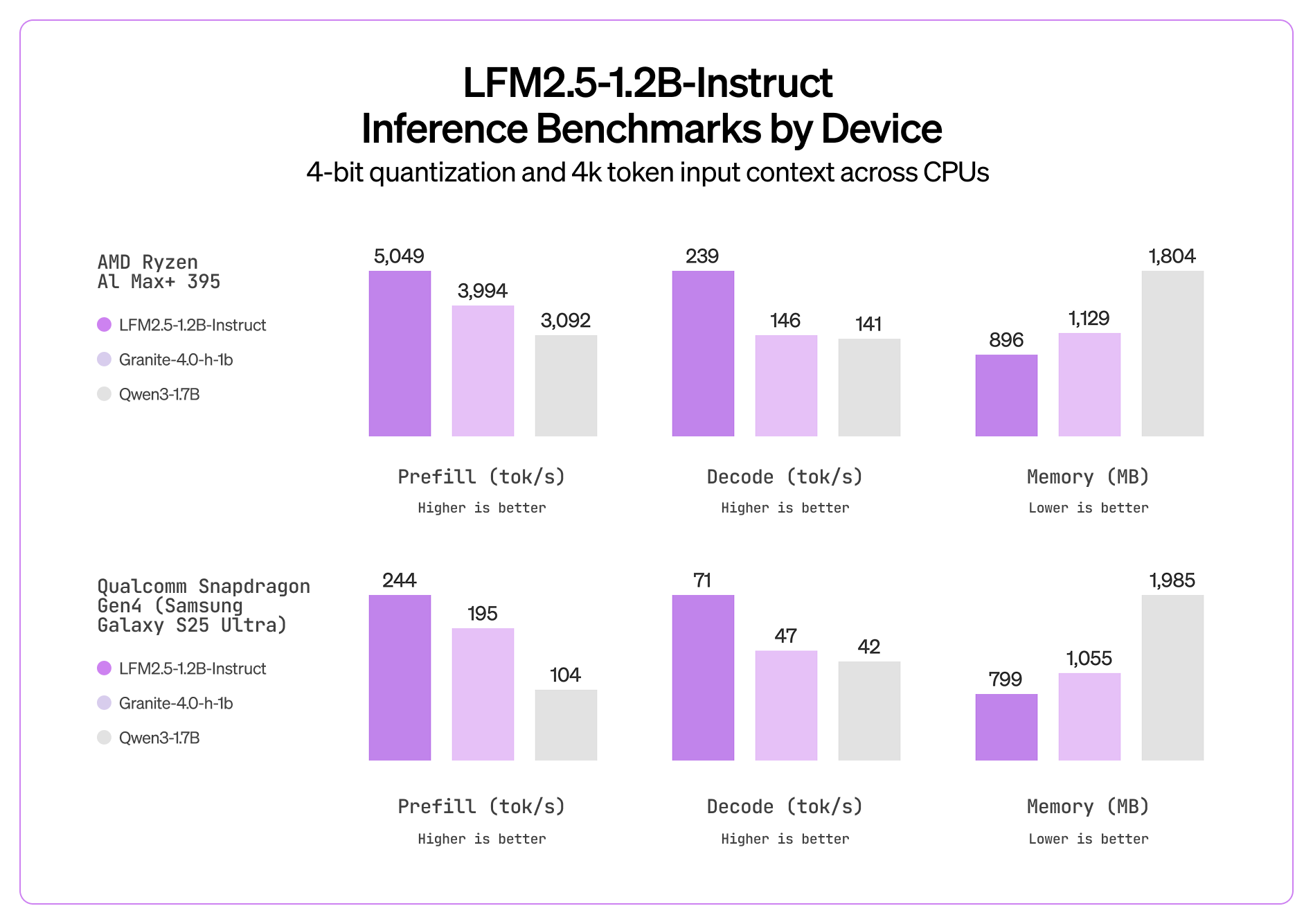

LFM2.5 は、同規模のモデルと比較して、低メモリプロファイルを維持しながら CPU 上で非常に高速な推論性能を実現します。

LFM2.5-1.2B-Instruct は、1B スケールにおいてトップクラスの性能と効率的な推論を両立しています。知識、指示追従、数学、ツール利用に関する各種ベンチマークで最高水準の結果を達成しつつ、ハイブリッドアーキテクチャにより極めて高速な推論速度を維持しています。これにより、ローカルコパイロット、車載アシスタント、ローカル生産性ワークフローといったオンデバイスのユースケースに自然に適合します。

日本語言語モデル

LFM2.5-1.2B-JP は、日本語向けに特化して最適化されたチャットモデルです。LFM2 でもすでに 8 言語の一つとして日本語をサポートしていましたが、LFM2.5-JP では、このスケールにおける日本語の知識および指示追従性能を最先端レベルまで引き上げています。本モデルは、文化的・言語的なニュアンスが重要となる日本語アプリケーションを構築する開発者に最適です。

日本語ベンチマーク結果

ビジョン・ランゲージモデル

LFM2.5-VL-1.6B は、更新された LFM2.5-base バックボーンを基盤として構築され、実環境での性能向上を目的にチューニングされた、刷新版のビジョン・ランゲージモデルです。本リリースでは、複数画像の理解能力が明確に向上しており、さらに多言語の視覚理解性能も改善されています。アラビア語、中国語、フランス語、ドイツ語、日本語、韓国語、スペイン語によるプロンプトを、より高い精度で処理することが可能です。

LFM2.5-VL-1.6B は、視覚およびテキストの両方の指示ベンチマークにおいて、より優れた指示追従性能を示しており、エッジ環境におけるマルチモーダルアプリケーションに最適な選択肢となります。

視覚およびテキストのベンチマーク結果

オーディオ・ランゲージモデル

LFM2.5-Audio-1.5B は、音声とテキストの両方を入力・出力モダリティとして受け付ける、ネイティブなオーディオ・ランゲージモデルです。音声認識、LLM 処理、TTS を個別のステージとして連結するパイプライン型アプローチとは異なり、LFM2.5-Audio は音声をネイティブに処理することで、各コンポーネント間の情報的な障壁を排除し、エンドツーエンドのレイテンシを大幅に削減します。

主な改善点として、レイテンシを大幅に低減したカスタムの LFM ベース音声デトークナイザー、CPU 推論向けの llama.cpp 互換 GGUF、そして ASR および TTS 性能全体にわたるベース言語品質の向上が挙げられます。

LFM2.5-Audio の中核には、新しいコンパクトな音声デトークナイザーがあります。これは、言語モデルのバックボーンから出力される離散トークンを高忠実度の音声波形へと効率的に変換する、LFM ベースのアーキテクチャです。LFM2.5 のデトークナイザーは、モバイル CPU 上で同一精度の場合、LFM2 の Mimi デトークナイザーと比較して 8 倍高速です。最高品質を実現するために、INT4 精度での量子化対応学習(QAT)も行われており、低精度のまま直接デプロイできるよう設計されています。その結果、FP32 における従来の LFM2 Mimi デトークナイザーと比べても、品質劣化はごくわずかに抑えられています。

以下は、男性音声および女性音声の両方で、次のテキストを発話させた際の、各種オーディオモデルの性能を示したものです。

「The birch canoe slid on the smooth planks. Glue the sheet to the dark blue background. It's easy to tell the depth of a well.」

LFM2.5 を実行する

高性能なモデルは、簡単にデプロイできるべきです。そのため、LFM2.5 は主要な推論フレームワークに対してデイゼロ対応で提供されます。

LEAP — クラウド API を呼び出すのと同じ手軽さで、iOS および Android にモデルをデプロイできる Liquid のエッジ AI プラットフォーム。

llama.cpp — CPU 推論のための定番ソリューション。すべてのモデルに対して GGUF チェックポイントが提供されており、最適化された量子化によって、あらゆるハードウェア上で効率的なデプロイが可能です。

MLX — Apple Silicon ユーザーは、MLX に最適化されたチェックポイントにより、ユニファイドメモリアーキテクチャを最大限に活用できます。

vLLM — GPU による高速化されたサービング向け。vLLM のサポートにより、本番環境での高スループット推論が可能になります。

ONNX — 幅広いハードウェアをサポートするクロスプラットフォーム推論。ONNX チェックポイントにより、クラウドからエッジデバイスまで、多様なアクセラレータおよびランタイムへのデプロイが可能です。

すべてのフレームワークは、Apple、AMD、Qualcomm、Nvidia のハードウェアにおいて、CPU および GPU の両方によるアクセラレーションをサポートしています。

ローンチパートナーシップ

また、AMD および Nexa AI と提携し、LFM2.5 ファミリーを NPU 向けに提供します。これらの最適化されたモデルはパートナーを通じて利用可能であり、オンデバイス推論を非常に効率的に実行できます。

これらの機能により、車載機器、モバイルデバイス、ノートパソコン、IoT デバイス、組み込みシステムなど、さまざまなデバイスにわたる新しいデプロイシナリオが実現されます。

推論速度ベンチマーク

はじめに

LFM2.5 ファミリーは現在、Hugging Face、LEAP、および当社のプレイグラウンドで利用可能です。

- LFM2.5-1.2B-Base: Hugging Face

- LFM2.5-1.2B-Instruct: Hugging Face, LEAP, Playground

- LFM2.5-1.2B-JP: Hugging Face, LEAP

- LFM2.5-VL-1.6B: Hugging Face, LEAP, Playground, Demo

- LFM2.5-Audio-1.5B: Hugging Face, LEAP, Playground

LFM2.5-1.2B の各バリアントは LFM2.5 モデルファミリーの一部であり、今後、モデルサイズや推論能力の拡張を通じて成長していく予定です。

LFM2.5 により、私たちは「どこでも動作する AI」というビジョンを実現します。これらのモデルは以下の特長を備えています。

オープンウェイト — 制限なくダウンロード、ファインチューニング、デプロイが可能

初日から高速 — Apple、AMD、Qualcomm、Nvidia のハードウェアにおいて、llama.cpp、NexaSDK、MLX、vLLM をネイティブにサポート

完全なモデルファミリー — カスタマイズ向けのベースモデルから、音声・視覚に特化したモデルまで、単一のアーキテクチャで多様なユースケースをカバー

エッジ AI の未来は、すでにここにあります。皆さんが何を構築するのか、楽しみにしています。

エンタープライズ向けの導入やカスタムソリューションについては、営業チームへお問い合わせください。実装の詳細については、技術レポートをご覧ください。

.svg)