私たちは、クラウドに依存することなく高性能 AI を提供できるようにモデルを設計しました。そのため、データは安全です。

当社のモデルは、メモリ使用量とコストが低く、コンピューティングに制約のある環境向けに調整されています。

クラウドへの依存関係を排除し、マルチモーダル入力を瞬時に処理することで、リアルタイムのパフォーマンスを実現します。

Liquid AI の SLM (小規模言語モデル) は、主要な SLM よりも優れたパフォーマンスを発揮します。

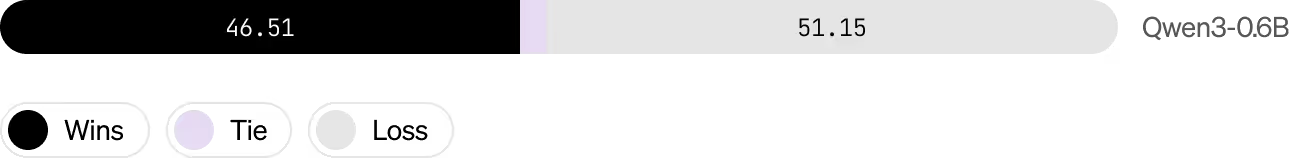

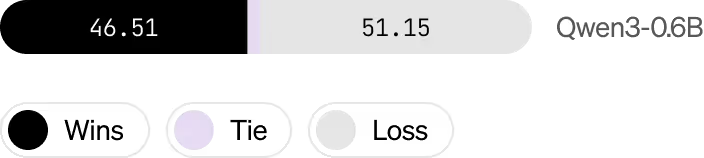

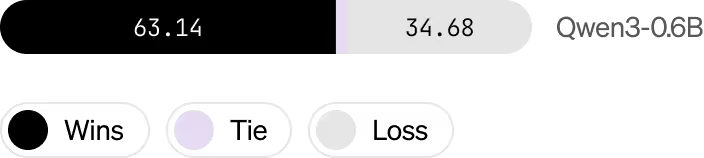

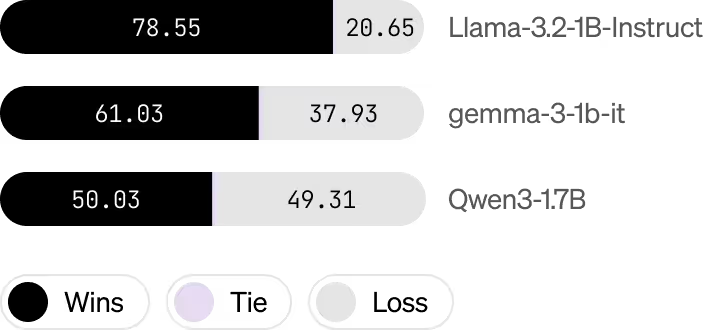

Head to head evaluation of chat capabilities in English*

英語でのチャット機能の直接評価*

英語でのチャット機能の直接評価*

当社のモデルはメモリが最適化されており、制約のあるハードウェア上でリアルタイムに展開できるように調整されています。

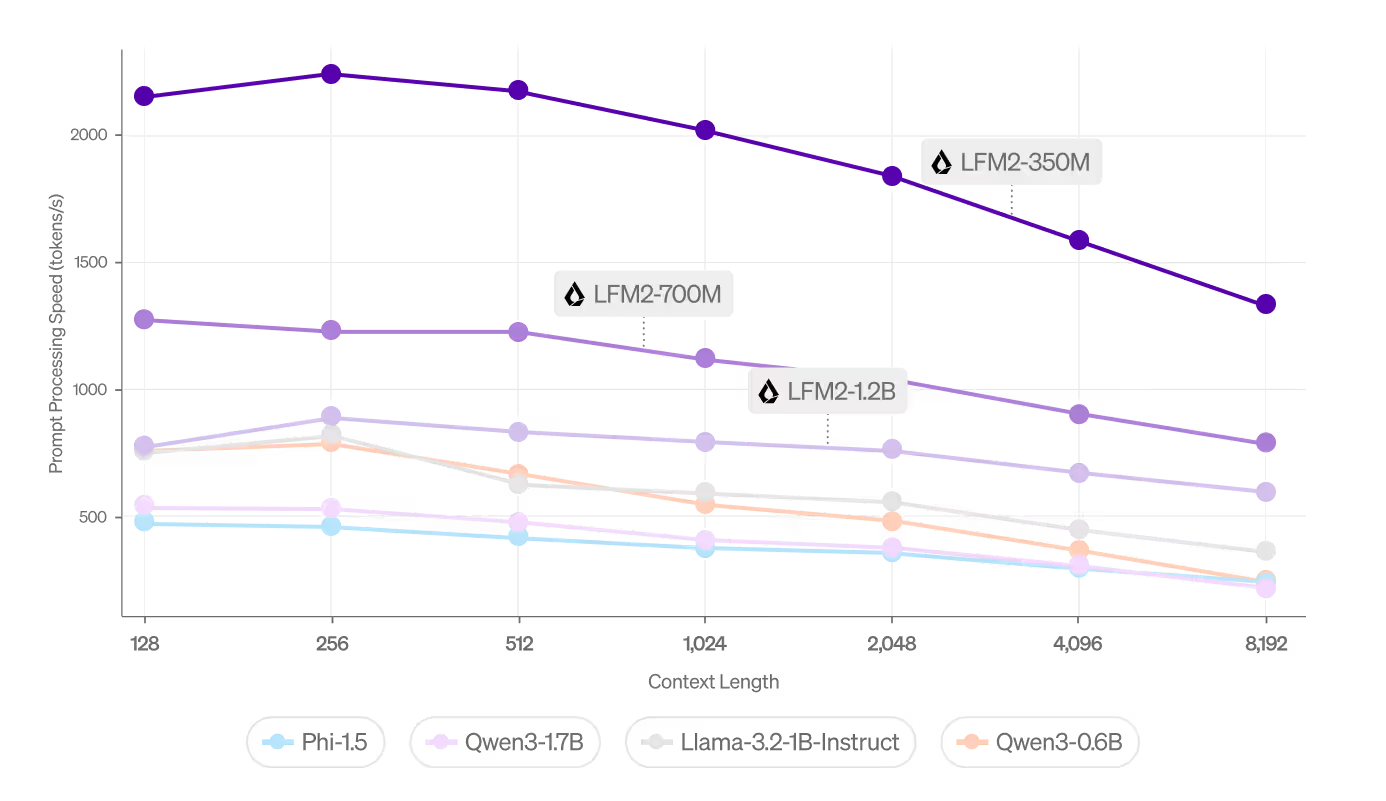

Liquid AI は、すべてのモダリティにわたって超短い最初のトークンまでの時間 (TTFT) と高スループット (tok/秒) を実現するように設計されています。

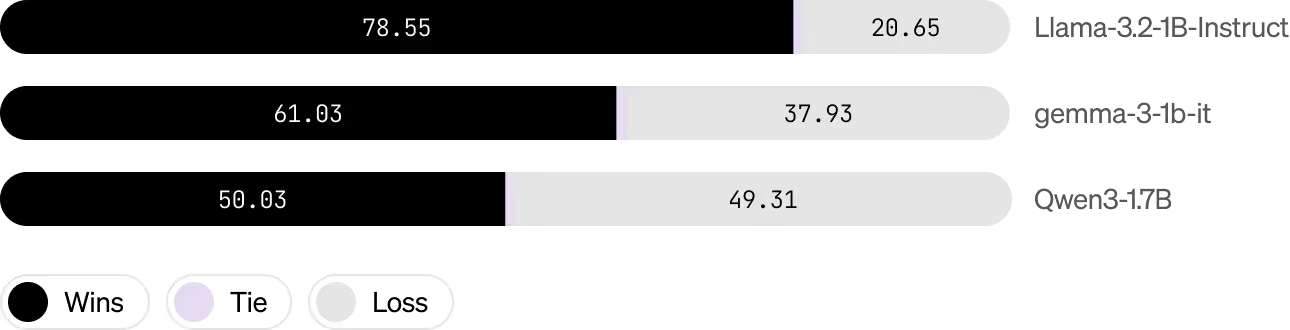

最初のトークンまでの時間 (TTFT)

最初のトークンまでの時間 (TTFT)

当社はモデルのライフサイクル全体を管理するため、お客様のチームは運用の複雑さではなく戦略的目標に集中できます。

当社は、合成データ、ラベル付きデータ、またはマルチモーダル データを大規模に生成し、お客様のユースケースに最適化された高品質の学習データを保証します。

当社はカスタム モデルを迅速に開発して厳密に検証し、お客様の要件に合わせたパフォーマンスを保証します。

CPU、GPU、自動車グレードのチップ、モバイル デバイス、エッジ展開などのハードウェア環境に合わせてモデルを正確に最適化します。

当社は透過的に機能し、お客様のチームがファインチューニング、検索拡張生成 (RAG)、またはカスタム統合を通じてモデルを個別に拡張または適応できるようにします。

当社は、世界をリードする企業に特化した LFM ソリューションを提供することに成功し、あらゆるレベルで明らかな改善を実証してきました。。

当社の価格モデルは、推論費用の削減、プロジェクトのタイムラインの加速、優れたモデル精度を通じて、予測可能なコストと実証可能な ROI を提供します。

ドメインの精度、応答スタイル、ハードウェアの設置面積のいずれを最適化する場合でも、FT CLI を使用すると、チームはプロンプト アダプターから完全なカスタムファインチューニングまで、Liquid の小型で高速なモデルの内部に直接アクセスできます。

当社の適応性の高い推論エンジンは、すべての環境においてパフォーマンス、メモリ効率、待ち時間を最小限に抑えるように最適化されています。

スマートフォン

低電力、低遅延環境向けに最適化された当社のモデルは、音声、ビジョン、パーソナライゼーション機能*に最適です。

ラップトップ

ローカル CPU または GPU に高性能モデルを展開し、エンタープライズ デスクトップ、フィールド デバイス、またはオフライン ワークフローに最適です。外部インフラに依存せず、データをローカルに保持する必要がある規制環境に最適です。

自動車

Liquid は、インフォテインメントの用途などで、組み込み自動車システム内でネイティブに実行されます。 OTA 対応のモデル更新と、QNX や組み込み Linux などの一般的な車載プラットフォームのサポートにより、超低遅延とオフラインの信頼性を実現するように設計されています。