私たちは、Liquid Foundation Model 2 シリーズの最新かつ現在最大のモデル LFM2-2.6B を発表できることを大変嬉しく思います。350M、700M、1.2B モデルの実績を基盤に構築された LFM2-2.6B は、卓越した性能を実現するために必ずしも巨大なスケールが必要ではないことを示しています。

スモールモデル、大きなインパクト

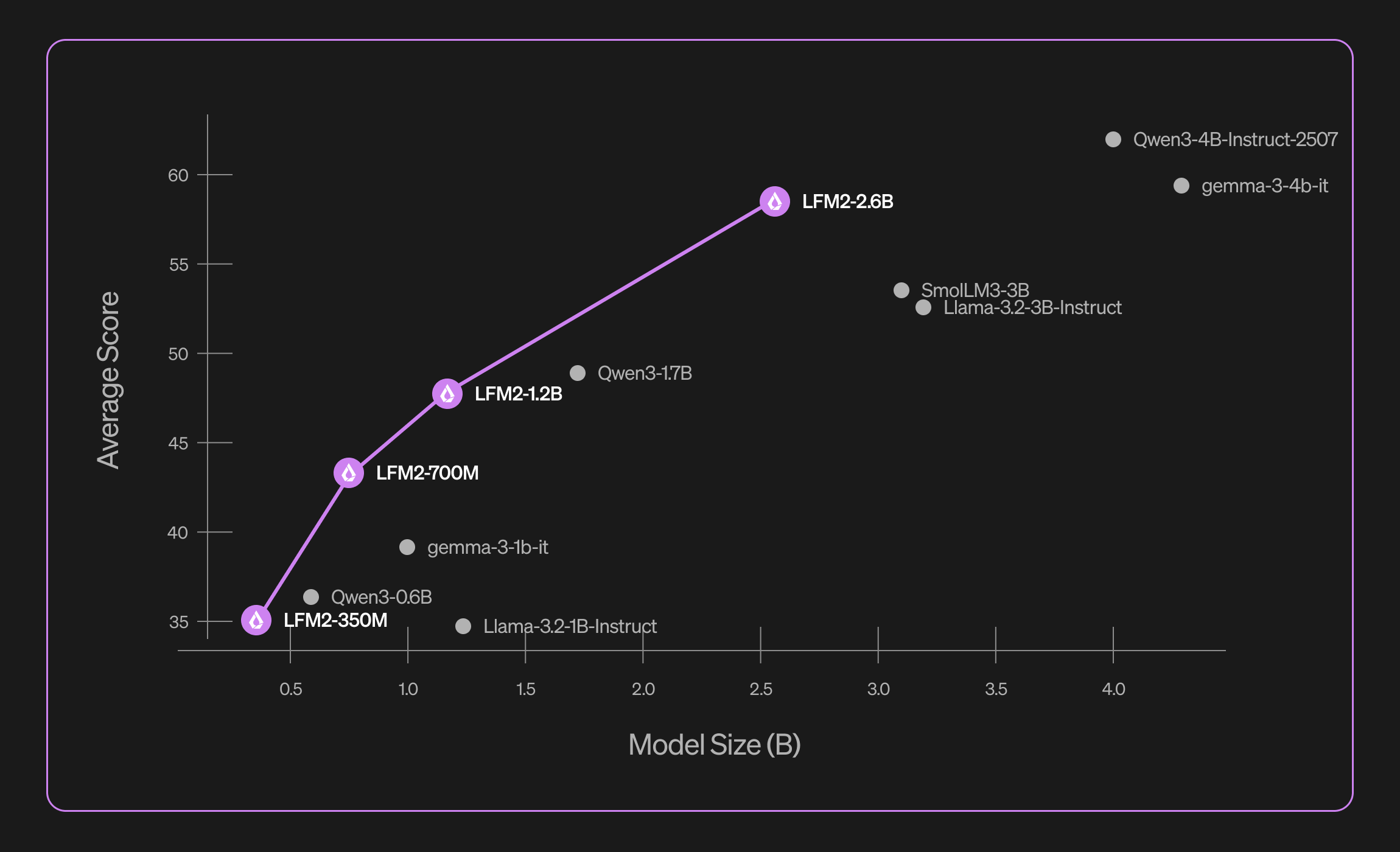

わずか 26 億パラメータ で構成される LFM2-2.6B は、Llama 3.2-3B-Instruct、Gemma-3-4B-it、SmolLM3-3B といった 3B+ クラスのモデルを上回る性能 を発揮します。

10 兆トークンで学習され、数学的推論の GSM8K で 82.41%、命令追従の IFEval で 79.56% を達成し、はるかに大規模なモデルに匹敵する成果を上げました。

また、英語と日本語に特化してチューニングされつつ、フランス語、スペイン語、ドイツ語、イタリア語、ポルトガル語、アラビア語、中国語、韓国語においても強力な性能を維持しており、グローバル用途に真に多用途なモデル です。

革新による高速化

LFM2-2.6B のハイブリッドアーキテクチャは、Grouped Query Attention(GQA)のブロックと短い畳み込み層を交互に配置することで、他の最新アーキテクチャと比較して 推論速度を大幅に向上 させ、KV キャッシュ要件を削減 します。これにより、応答速度の向上と大規模展開時のコスト削減を同時に実現します。

オープンで誰でも利用可能

LFM2-2.6B は、Hugging Face 上で LFM Open License のもと公開されており、世界中の開発者や研究者が最先端の効率的な AI にアクセスできるようになりました。

LFM2 シリーズは、効率的な AI の限界を押し広げ続けています。適切なアーキテクチャとアプローチがあれば、小規模なモデルでも計算負荷を増やすことなく エンタープライズグレードの性能 を発揮できることを証明しています。今後も基盤モデルを拡張し、この効率性をより多くのデバイスに届け、新しい応用分野を切り拓いていきます。

.svg)